音楽を聴くとき、そこになんらかの声が収録されているのであれば、たいてい耳はその声に注意が傾くことだろう(当然そうでない場合も往往にしてある)。仮にその言葉(あるいは歌詞)が聞き取れなかったとしても、声を通じて、その音楽のフィーリングを感じ取ることができたりもする。声そのものには多かれ少なかれ、なんらかのアテンション、発せられた意味以上のさまざまな情報が付帯している、ということはあらためていうまでもない。

では、AIによって生成された声にはどのような情報が付帯するのであろうか。それが特定の個人の声だった場合、そこにどんな意味が生じるのか。実際に、音声変換によるAIの声真似(ディープフェイク・オーディオ)は一般的な技術になりつつあるそうだが(※)、そうなると聞く側には、その声にどのように向き合うべきか、という新たな問題が浮上する。

AIは「声を聞く」という行為にどのような影響をもたらすのか。本稿では、AIによって生成されたアンディ・ウォーホルの声に感じたことから、ライターのimdkmが「私たちが声になにかを聞き取ってしまうこと」について考える。

※PHILE WEB「Amazon、Alexaが故人の声でしゃべる実験的機能を公開。わずか1分の録音から生成」参照(外部サイトを開く)

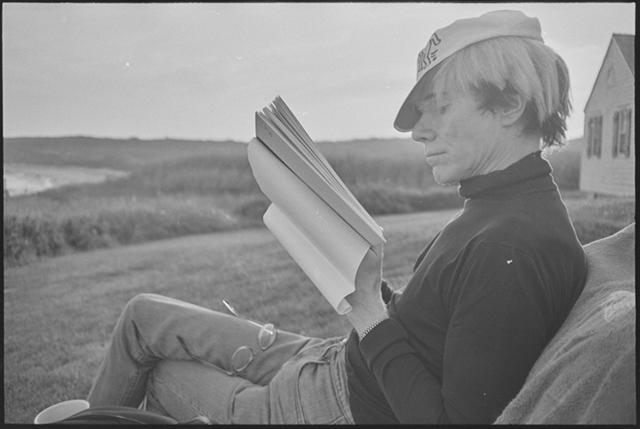

メイン画像:Netflix『アンディ・ウォーホル・ダイアリーズ』より Andy Warhol Foundation/Courtesy of Netflix

「AIアンディ・ウォーホル」の本物らしい声が呼び起こすざわつき

Netflixで2022年に公開されたドキュメンタリーシリーズ、『アンディ・ウォーホル・ダイアリーズ』。アンディ・ウォーホルが口述し、死後に出版された同名の「日記」に基づいたドキュメンタリーだ。「日記」が浮かび上がらせるウォーホルの足跡を、ウォーホルとともに過ごした人々の証言とあわせて再構築しながら、今日的な観点から振り返る、全6エピソードの長編だ。

Netflix『アンディ・ウォーホル・ダイアリーズ』トレイラー映像

このドキュメンタリーを何気なく再生して驚いた。ウォーホルそのものというほかない声が、ナレーターとして日記を読みあげているのだ。じつは、あたかも本人のようなこの声はAI(機械学習)によって合成された「AIアンディ・ウォーホル」というべき音声で、ウォーホルのものではない。

このモデルを構築したのは、音声合成エンジンを提供する企業Resemble AI。学習に用いられたのは、1970年代から80年代のアーカイブから選りすぐられたほんの3分12秒の音声データだ。そこからテキスト・トゥ・スピーチ(テキスト読みあげ)で音声を合成しているほか、細かいニュアンスを表現するため、声優による朗読をウォーホルの声色に変換するスタイル・トランスファーも用いられている(※)。

同社によるデモンストレーションを見ると、わずかなデータセットから十分に「ウォーホルらしい」声を再現していることに驚かされるし、単に精巧なモデルをつくるだけではなく、より「らしさ」を突き詰めるための調整も繊細に行なえるようになっていることがわかる。

※Resemble AI社のサイトでは、いかにして「AIアンディ・ウォーホル」の音声が生成されているのか動画や画像とともに説明されている(外部サイトを開く)

Netflix『アンディ・ウォーホル・ダイアリーズ』より Andy Warhol Foundation / Courtesy of Netflix

声優が読み上げた声をAIで変換するデモ動画

AIのアンディ・ウォーホルが、生々しさの残る私生活の記録を読みあげる。これはAIだと頭ではわかっていても、その声がつくりだす「本物らしさ」になにかしらの迫真性を覚えてしまう。よく似ていることそのものよりも、騙されていると知りつつもそこに説得力を感じ取ってしまう自分の耳に、うっすらとした居心地の悪さを覚えた。

「声」は、存在しない身体や過去をも捏造しうるのではないか

『アンディ・ウォーホル・ダイアリーズ』のように、著名人の声をAIによってモデル化して合成する試みは、なにも突然あらわれたわけではない。

たとえば日本では、2019年に発表された「AI美空ひばり」(※)が賛否を含めて大きな話題になった。あるいは、松任谷由実が「AI荒井由実」と時代を超えた共演を果たしたのも記憶に新しい。さらには、このリストに東京大学AI研究会を名乗るグループによる「故安倍元総理追悼AIプロジェクト」を並べてもよいかもしれない。

※「AI美空ひばり」の歌唱は、NHKやレコード会社などに残る音源・映像をもとにAIによるディープラーニングを活用して実現した(YouTubeを開く)

AIでつくられた荒井由実のボーカルと、2022年の松任谷由実によるデュエット曲“Call me back”を聴く

こうしたディープフェイクは、耳目をひく新奇さゆえに驚きとともに歓迎されたり、あるいは直感的に拒絶されたり、またあるいは倫理的な批判を受けたりとさまざまな反応を呼び起こしてきた。とはいえ、ここでディープフェイクの是非をあらためて論じようなどとは思わない。むしろ、私は逆向きの問いに、つまり「私たちが声になにかを聞き取ってしまうこと」自体に関心がある。

そんなことを考えているときに、ある作品を思い出した。フォルマント兄弟(三輪眞弘+佐近田展康)の『フレディの墓』だ。

とある著名なボーカリスト、フレディ・Mの歌声を再現し、共産主義者のアンセム“インターナショナル”を歌わせる。機械学習の爆発的な発展に先駆ける2009年に発表された本作において、歌声の再現は佐近田展康による職人的なアルゴリズムの調整によるものだ。ゆえに、今日のディープフェイクと比べれば、見事な模倣とは言い難いかもしれない。それでもなお、かのフレディを感じる瞬間はたしかにある。

そのコンセプト・テキスト「デジタル・ミュージックにおける6つのパースペクティブ」(※)が示しているように、この作品の目論見のひとつは、声と身体の関係を、録音テクノロジーを蝶番として転倒させる(身体があるから声があるのではなく、声によって身体が、なんなら過去が捏造される)ことにある。

※フォルマント兄弟によるコンセプト・テキスト「デジタル・ミュージックにおける6つのパースペクティブ」を読む(外部サイトを開く)

フォルマント兄弟『フレディの墓』より、“インターナショナル”を歌うフレディ・M

とすれば、ここでディープフェイクにおける「故人を蘇らせる」ことのつくり手の倫理的な問題は、「故人の姿を聞き取ってしまう」ことをめぐる受け手の認識の問題にも接続されているといってよい。つまり、テクノロジーを前にすると、「聴くことの倫理」もまた要請されるのだ。

「聴くことの倫理」といっても、それは声の主に対する傾聴の姿勢のような話ではなくて(それが非常に重要であることは疑いようがないが)、もっと即物的な、というよりもテクノロジーによって即物的なステータスを与えられてしまった声に対する、新しい心構えである。自分の経験に引き寄せるならば、AIのアンディ・ウォーホルの声に「それらしさ」を感じてしまう、その居心地の悪さに対する思考こそが求められるのではないか。

さて、もうひとつ、『フレディの墓』(とそのコンセプト・テキスト)が指摘する重要なポイントは、それが録音された音楽としてのポップミュージックに焦点をあてていることだ。そしてやはり、いま声を聴くことの倫理について考えるとき、『フレディの墓』がそうであるように、出発点としてポップミュージックはある程度有効であるように思える。

「歌声」を聴くとき、人はそこになにを感じ取っているのか

声について語るとき、歌声は少し特殊で重要な位置をしばしば占める。

というのも、声がもっぱらその意味内容と不可分とされる一方で、歌声はそうした意味に還元されない響きをつねに持つからだ(たとえばロラン・バルトが「声のきめ」がもたらす官能を語るとき、もっぱらそれが声楽論であることを念頭に置くべきだろう)。

一方で、歌声の音楽としてのポップミュージックは、身体性と強く結びついた声の官能を強く相対化するような側面も持つ。

ポップミュージックは、いつもいかにして声を商品=録音物に落とし込むかに注意を払ってきた。それは魅力的な歌声の忠実な録音という動機以上に、望ましい声をつくりだすという創造的な動機を含んでいた。それゆえに、ピッチの上げ下げやイコライジング、マイクの選択、ダブリングやハモりなどの多重録音、トーキングボックスやボコーダー、オートチューンまで、声はつねに操作の対象であり続けている。

むしろ、そうした操作を前提として、ポップミュージックの声、そしてそれを支える身体さえも組み替えられてきた。その最たるものが合成音声による歌唱だろう。そこにもはや身体はない。歌声の合成自体は、IBM 7094による“デイジー・ベル”の録音(1961年)を引き合いにだすまでもなく、半世紀以上の歴史を持つ(※)。

※IBM 7094による“デイジー・ベル”は、世界で初めてのコンピュータによる歌唱として知られる(YouTubeを開く)

Francis and the Lights“See Her Out”を聴く

さらに、ボーカロイドの登場以降は、その歌声のルーツにある身体ではなく、合成された歌声そのものにキャラクターを投影することも一般的になってきている。

「声」にまつわる思考の新たなを呼び起こす、耳中華のいびつな歌

録音物のなかに封じ込められた「声」にとって、身体は依然として重要なファクターではあるが――とりわけそれがきわめてパーソナルな、あるいはアイデンティティーをめぐる表現と結びついたときに、歌う身体との関係を無視するわけにはいかない――、しかし身体だけが重要なのではない。

その極北に耳中華をおくことは突飛ではあるだろうが、あながち間違っていないだろう。

耳中華“テント買おうと思った”を聴く(Apple Musicで聴く)

耳中華の歌で用いられる、いわゆる「ゆっくりボイス」を生成する合成エンジン「AquesTalk」は、ほかの多くのエンジンとは異なり音声素材の録音なしに完全に手作業で構築されている。さらには、カットアップの過程で音節ごとにピッチシフトやタイムストレッチがほどこされることで、耳中華の曲は声のバーチャルな統一性さえも喪失している。

実在の身体とも、キャラクターに託される身体とも距離をおいた声がここにある(しいていえば、この10年来インターネットを支配する「ゆっくりボイス」という現象そのものが、身体の代理を果たしているのかもしれないし、その文化的背景を捨象することの是非はあるだろう)。

いびつに伸び縮みする耳中華の歌は、AIによる合成音声がもたらすような自然さとは程遠い。そこには、声がもたらす真正性、もっともらしさの感覚は希薄だ。不自然さのなかにキャラクターの愛嬌を聞き取るようなこともほとんどないように思う。

しかし、それがこの音楽の価値を減ずるということはまったくない。むしろ、もっともらしさを持たないことが美点とさえいえる。ある意味では、新たな「聴くことの倫理」を築くにあたっての重要な出発点になるのではないだろうか。

- フィードバック 23

-

新たな発見や感動を得ることはできましたか?

-